Особенности Stable Diffusion

Название нейросети Stable Diffusion отчасти отражает суть этой нейросети: она использует технику диффузии для генерации изображений из текста. Это процесс, при котором случайный шум постепенно удаляется из изображения, пока не получится четкая картинка. При этом многие расшифровывают слово Stable в названии как отражение высокого качества итоговых проектов: нейросеть менее склонна к непредсказуемому поведению и способна стабильно создавать качественные и реалистичные изображения, не теряя деталей и не вызывая артефактов.

Stable Diffusion — это мощный и гибкий инструмент для тех, кто хочет создавать и изменять изображения по своему вкусу и потребностям. Многие дизайнеры, художники и специалисты по машинному обучению считают, что он превосходит другие сервисы для генерации изображений по качеству, скорости работы и возможностям.

Вот несколько его ключевых отличий от других генеративных нейросетей. Stable Diffusion работает в латентном пространстве изображений, а не в пиксельном пространстве, как большинство других моделей. Это делает ее быстрее и экономит память. Латентное пространство — это абстрактное представление изображения, которое содержит его основные характеристики и стиль. Пиксельное же пространство — это конкретное представление, которое состоит из множества точек (пикселей) разного цвета.

Stable Diffusion основана на открытом исходном коде, поэтому программу на ее основе можно скачать и запустить на своем компьютере, а также при желании даже обучить на своих данных. Сервис поддерживает загрузку пользовательских моделей и сборок — различных авторских настроек работы Stable Diffusion, «заточенных», например, под конкретные стили и эффекты изображений.

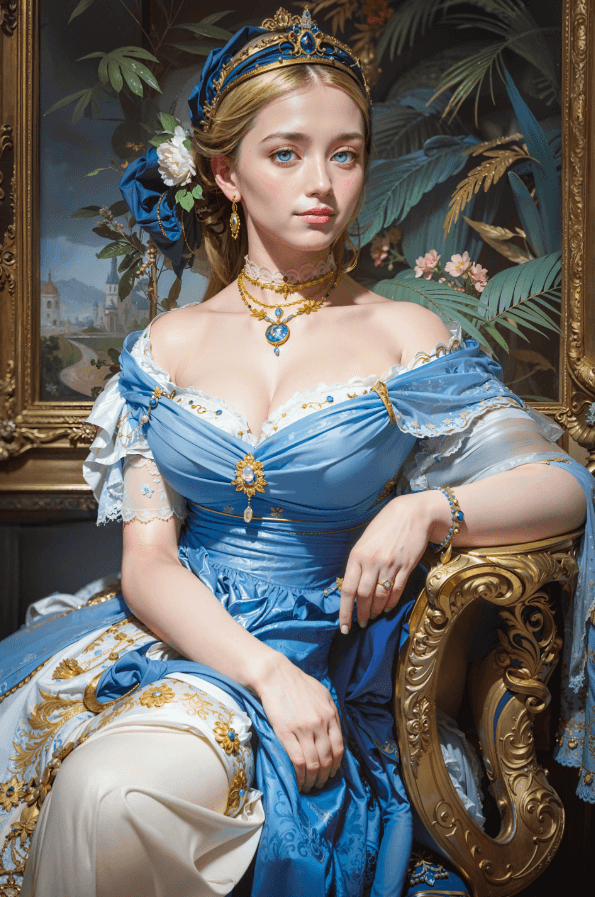

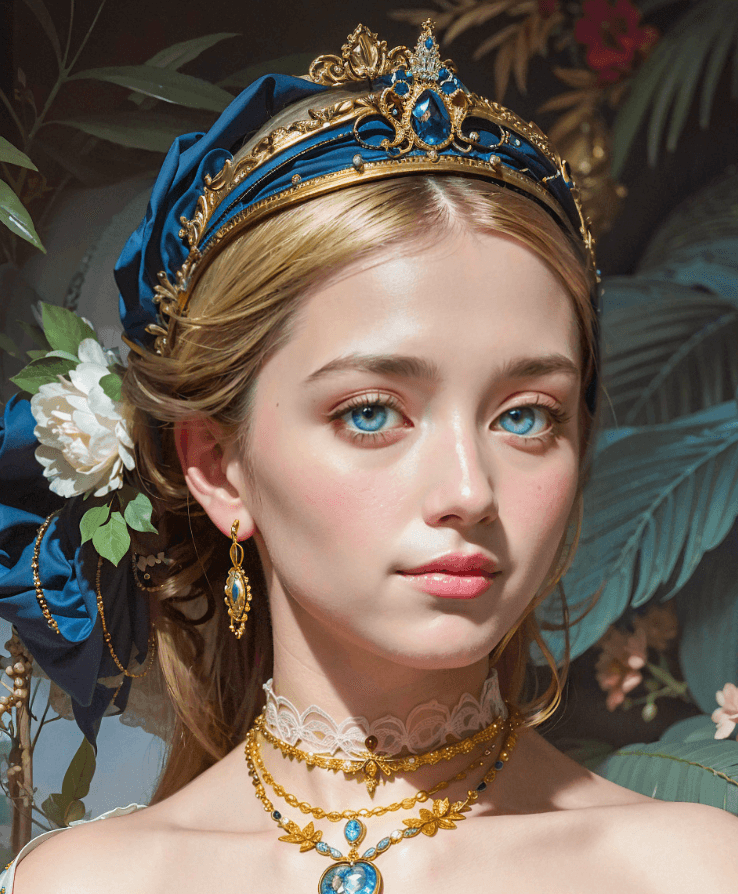

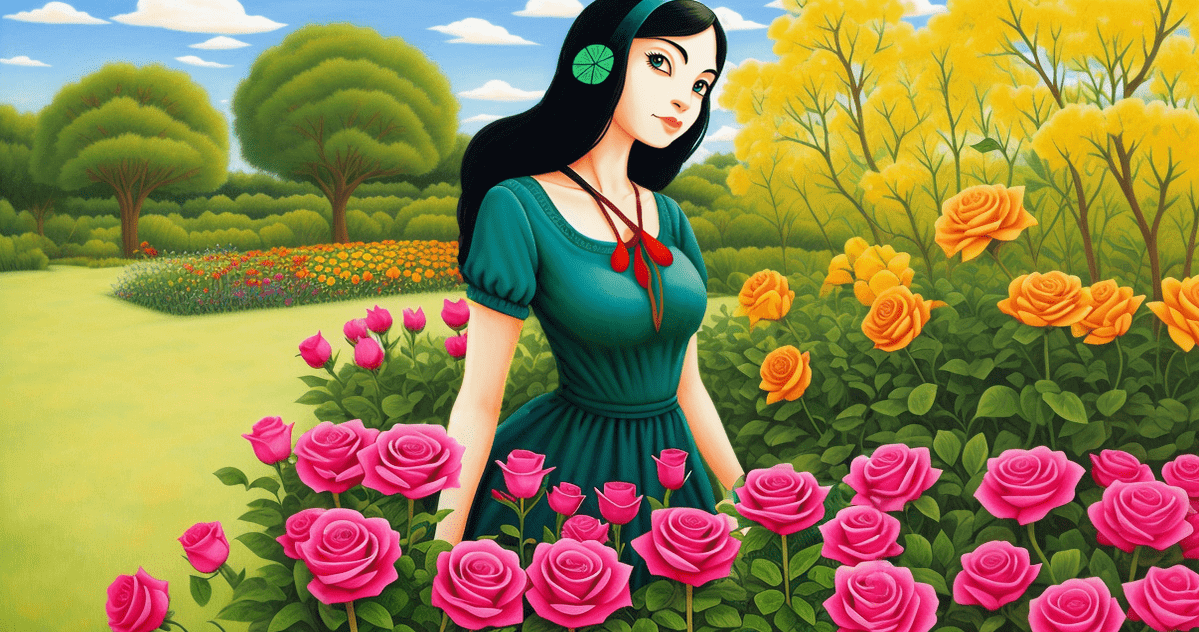

AI-портрет принцессы, созданный в Stable Diffusion дизайнером Andrei Vyktor Georgescu. Использована не только функция генерации, но и функция улучшения качества, детализации и снижения шума. Источник

AI-портрет принцессы, созданный в Stable Diffusion дизайнером Andrei Vyktor Georgescu. Использована не только функция генерации, но и функция улучшения качества, детализации и снижения шума. Источник

Какой вы дизайнер?

5 минут

Какой вы дизайнер?

Пройдите тест и узнайте, какая дизайн-профессия подойдет именно вам

Как устроена

Мы постараемся не усложнять статью техническими подробностями и рассказать о том, как устроен этот генеративный инструмент, простыми словами. Stable Diffusion состоит из нескольких компонентов, каждый из которых работает на основе отдельной нейронной сети. Они действуют в синергии друг с другом, выполняя свою часть работы.

Исходными данными для генерации картинки является текстовый промпт — запрос, который описывает словами желаемое содержание и стиль изображения. Он может состоять из разных элементов, таких как объекты, атрибуты, отрицания и т.д. Промпт помогает нейросети понять, что именно вы хотите увидеть, и влияет на то, как Stable Diffusion будет использовать свои компоненты при генерации изображения.

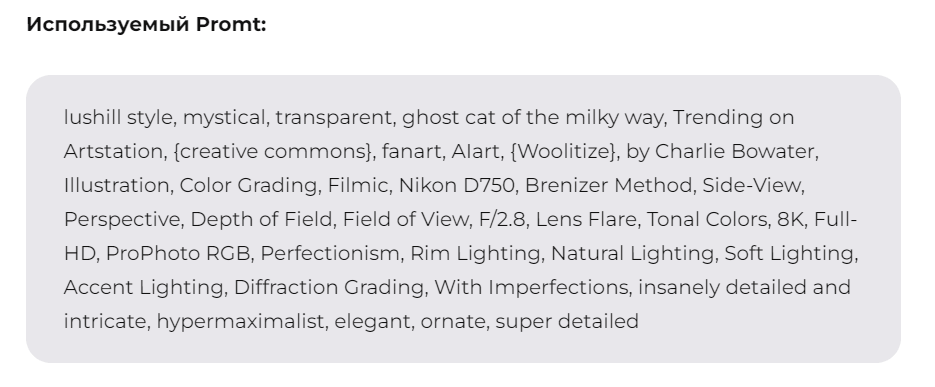

Пример промпта и созданных по нему картинок от «Лайфхакера». Источник

Пример промпта и созданных по нему картинок от «Лайфхакера». Источник

Далее в процесс генерации вступают следующие элементы Stable Diffusion.

- Кодировщик текста (CLIPText). Он преобразует текстовую подсказку в специальный числовой код, который содержит информацию о том, что́ заказчик хочет видеть на изображении. Методика преобразования текста CLIP (Contrastive Language-Image Pre-training) была чуть ранее разработана OpenAI. CLIP использует большой набор пар текста и картинок, собранных из интернета, и учит модель сравнивать их между собой. Таким образом, модель может оценивать, насколько хорошо текст описывает изображение или насколько хорошо изображение соответствует тексту.

- Создатель информации об изображениях и планировщик (UNet + Scheduler). Эти компоненты отвечают за генерацию изображения по переданным в них данным. UNet принимает на входе шум и постепенно преобразует его в изображение с помощью латентного пространства. Это происходит в несколько последовательных циклов. При этом модель использует данные о запросе пользователя, созданные на предыдущем этапе. Scheduler — это алгоритм, который управляет процессом добавления и уменьшения шума в изображении, чтобы сделать его соответствующим текстовой подсказке. Итог работы этого компонента — обработанный массив информации, описывающий итоговую картинку.

- Декодер. Он отвечает за отрисовку изображения в большем размере из переданного массива информации.

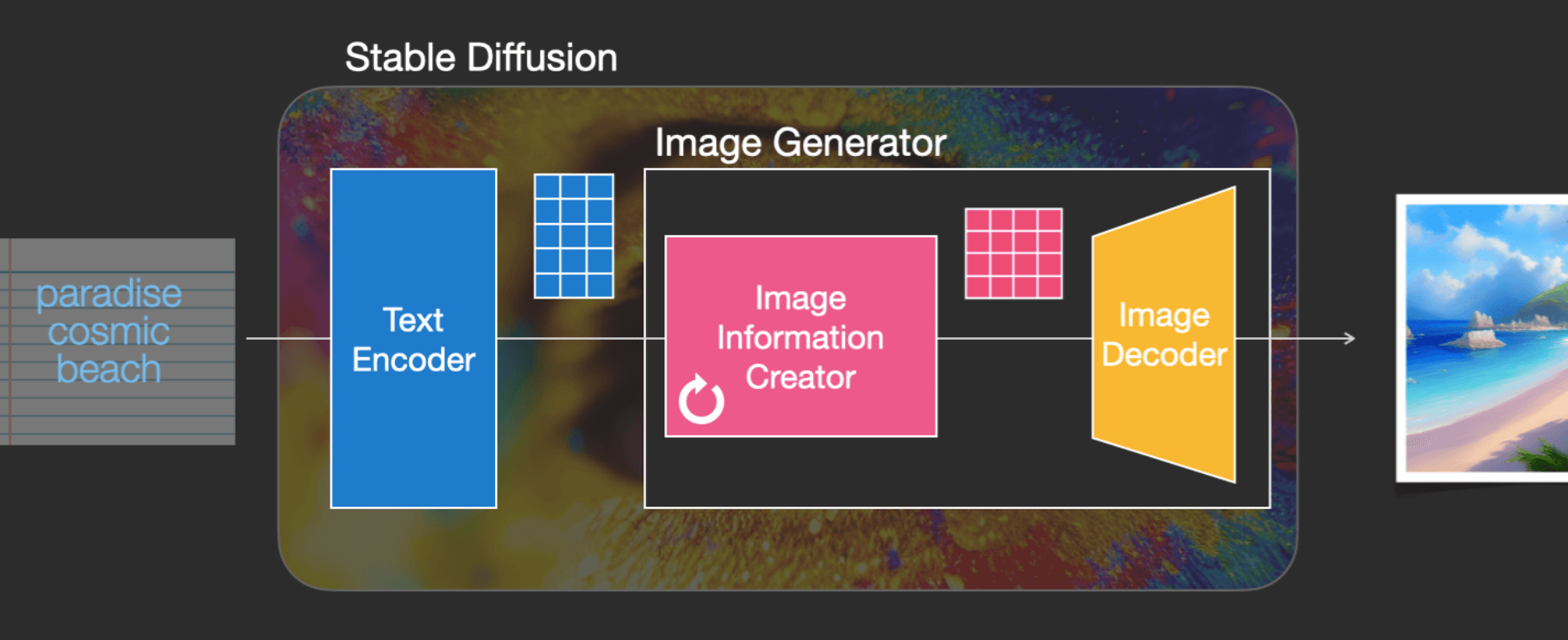

Схема работы системы. Источник

Схема работы системы. Источник

Конечно, это сильно упрощенная схема, однако она дает представление о внутреннем устройстве Stable Diffusion. В основе работы инструмента лежит механизм диффузии, который поэтапно добавляет и удаляет шум из изображения. Это позволяет прорабатывать даже мельчайшие детали, дорисовывать и редактировать изображения, используя информацию из текстового промпта.

Читайте также:

14 лучших нейросетей для создания изображений в 2024 году

Возможности

Этот инструмент многофункционален. Вот основные задачи, которые дизайнеры и художники могут решить с помощью него. Генерировать изображения по текстовому описанию. Пожалуй, это самая используемая функция. Картинки могут быть как фотореалистичными, так и художественными (стилизованными). При этом у пользователей есть большая вариативность в использовании текстовых промптов: можно составлять их буквально из пары слов, а можно пользоваться специальными подробными шаблонами, которые описывают каждый аспект будущей картинки.

Работы Photinia Art для календаря на 2024 год, созданные с использованием Stable Diffusion. Источник

Работы Photinia Art для календаря на 2024 год, созданные с использованием Stable Diffusion. Источник

Пародировать стили реальных художников. Эта функция позволяет сразу генерировать картинки, копирующие стилистику известных мастеров, или загрузить свое изображение (к примеру, фотографию) и отредактировать его в нужном стиле, сохраняя детали и портретное сходство. Так, можно попросить Stable Diffusion преобразовать ваше фото в живопись в стиле Ван Гога или Пикассо. Цвета, формы и текстуры будут адаптированы к выбранному стилю. Однако помните, что выдавать подобные работы за свои нельзя, это может нарушать авторские права художников с уникальным стилем, которые зарабатывают своим творчеством.

Портрет в стиле старых мастеров от Snark AI. Источник

Портрет в стиле старых мастеров от Snark AI. Источник

Генерировать изображение по референсам. Часто нужно создать не просто картинку, а картинку, похожую на какую-то другую по цвету, композиции, позе персонажа и т.д. Для этого дизайнер может загрузить исходный референс и попросить Stable Diffusion выполнить генерацию по нему, внеся конкретные изменения, например повторить цвета референса, но изменить расположение объектов в кадре.

Портрет в стиле масляной живописи от Photinia Art. Источник

Портрет в стиле масляной живописи от Photinia Art. Источник

Дорисовывать наброски. Эта функция позволяет вам загрузить в качестве основы собственный и сгенерированный набросок в любом формате, например фотографию карандашного эскиза. Stable Diffusion умеет сохранять композицию, распознавать конкретные объекты по формам, а также добавлять детали, цвета и реалистичность к наброску, чтобы создать полноценное изображение.

Узнайте свой путь в дизайне

Узнайте свой путь в дизайне

Пройдите короткий тест и откройте профессию, которая подходит именно вам. В подарок — доступ к 20+ бесплатным гайдам и интенсивам для старта

узнать

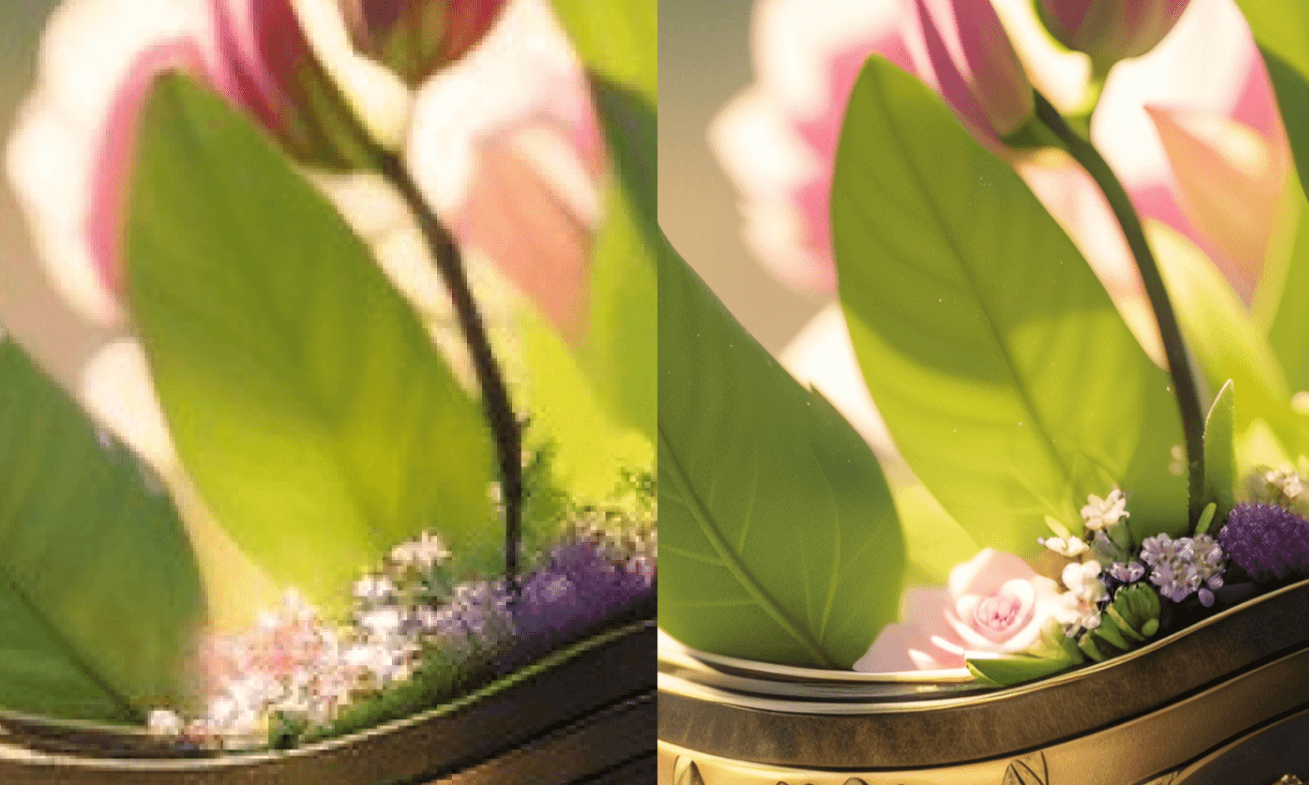

Улучшать разрешение изображений. Эта функция называется апскейлинг и позволяет делать картинки более четкими и детализированными. Это может понадобиться в самых разных ситуациях. К примеру, когда в качестве исходника для проекта заказчик предоставил фото продукта в низком разрешении или с артефактами — пикселизацией, размытием и др. Другой пример — когда исходник имеет невысокое разрешение для загрузки на сайт или создания рекламного баннера (512 x 512 или ниже), его можно увеличить в несколько раз (до 1024 x 1024) с сохранением и даже улучшением детализации.

Пример AI-апскейла картинки из гайда Дмитрия Чаплинского. Источник

Пример AI-апскейла картинки из гайда Дмитрия Чаплинского. Источник

Расширять изображения. В работе дизайнерам часто требуется увеличить размеры уже имеющейся картинки, но встроенные функции Photoshop не всегда дают качественный результат, а в других графических редакторах этой опции либо совсем нет, либо она требует установки дополнительных плагинов. Эта функция позволяет вам расширять фон на изображениях, добавляя новые детали и объекты. С помощью Stable Diffusion вы можете выполнить процедуру, обратную кадрированию, — расширение границ с дорисовкой недостающих частей. Запрос при этом может выглядеть так: «Расширь фон на этом фото пляжа сверху и снизу, добавив сверху больше неба, а снизу — песок и крабов». Нейросеть постарается гармонично дополнить картинку, увеличив при этом ее размер по вертикали.

Расширение иллюстрации с последующей обработкой результата для улучшения качества от Дмитрия Чаплинского. Источник

Расширение иллюстрации с последующей обработкой результата для улучшения качества от Дмитрия Чаплинского. Источник

Заменять одни элементы на другие. В приложение можно загрузить картинку и задать запрос и замене конкретных элементов на другие, например «замени банан на яблоко». При этом можно сохранить все остальные части картинки, цвета и композицию, без следов удалив один предмет и органично вписав на его место другой с учетом теней, стилистики и перспективы. При этом Stable Diffusion сама найдет объект на рисунке по его названию.

Заполнять пробелы. Еще одна интересная возможность, которая пригодится иллюстраторам или художникам. Если на картинке нужно исправить только одну деталь (к примеру, предложить заказчику несколько вариантов глаз персонажа), можно загрузить в Stable Diffusion картинку с пробелами в соответствующих местах, и система постарается заполнить их в соответствии со стилистикой и окружением.

Анимировать. Некоторые модели Stable Diffusion позволяют генерировать короткие ролики или GIF-файлы по промптам. При этом часто можно выбрать способ движения, например приближение, отдаление, вращение, перемещение камеры относительно объекта съемки слева направо и т.д.

Примеры анимации с помощью расширения AnimateDiff в интерфейсе Automatic 1111 от Nerual Dreming. Источник

Таким образом, Stable Diffusion — это мощный, многофункциональный и гибкий инструмент для тех, кто хочет создавать и изменять изображения. Он способен закрыть множество потребностей дизайнеров, художников и иллюстраторов в сфере работы с графикой.

Читайте также:

Чат-бот в стиле ретрокиберпанк от студентов Contented: эксперимент, который удался

Как пользоваться Stable Diffusion

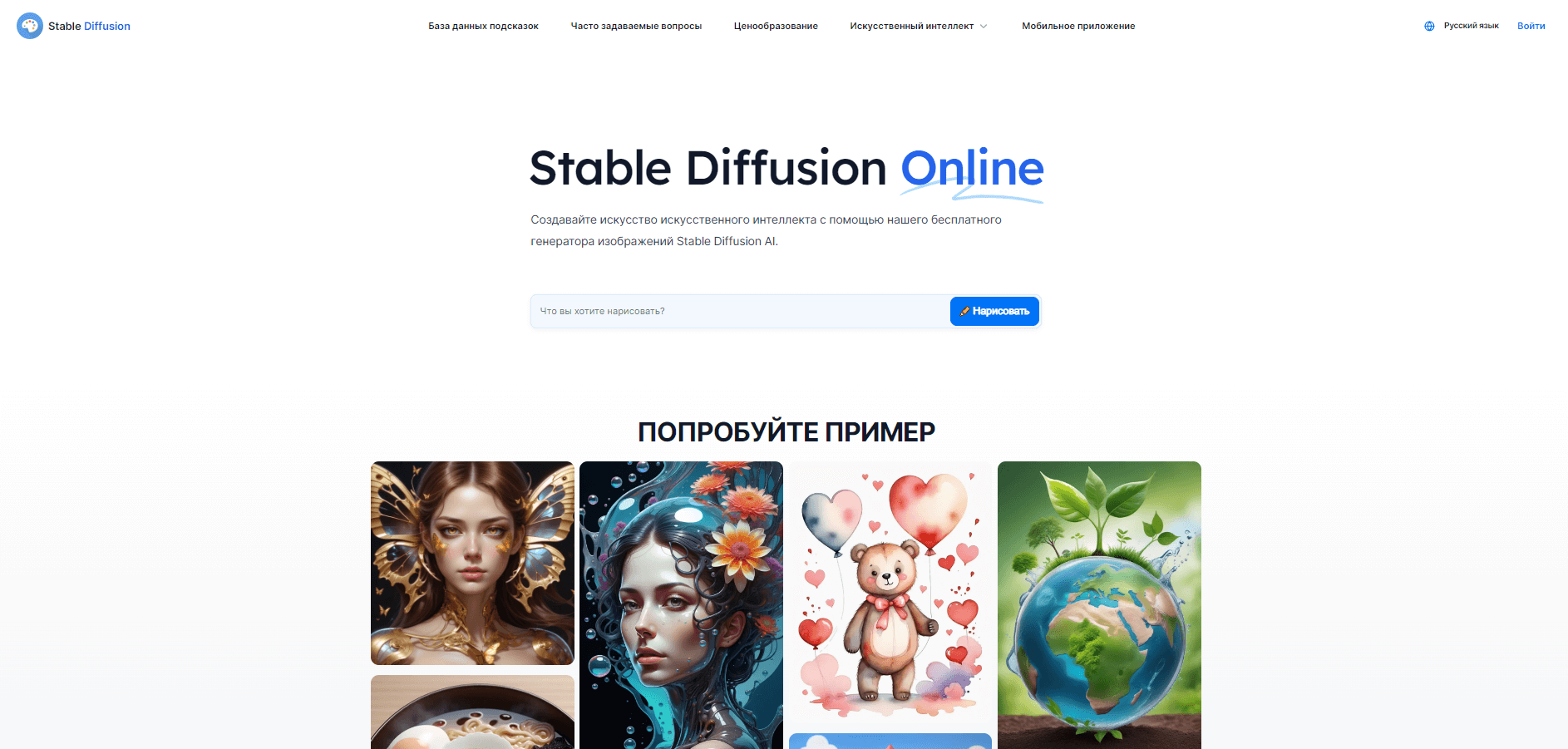

Онлайн-версия сервиса — это простая возможность бесплатно использовать Stable Diffusion для создания собственных изображений. В ней мало настроек, и она доступна любому. Вот как ей пользоваться.

- Перейдите на веб-сайт одной из версий, например этот или этот.

На главной странице вы увидите строку, в которую нужно ввести текстовый запрос. Придумайте его сами, возьмите из предлагаемых сервисом примеров или из интернета. Система попросит вас войти через Google-аккаунт или зарегистрироваться в сервисе: выберите наиболее удобный для вас вариант.

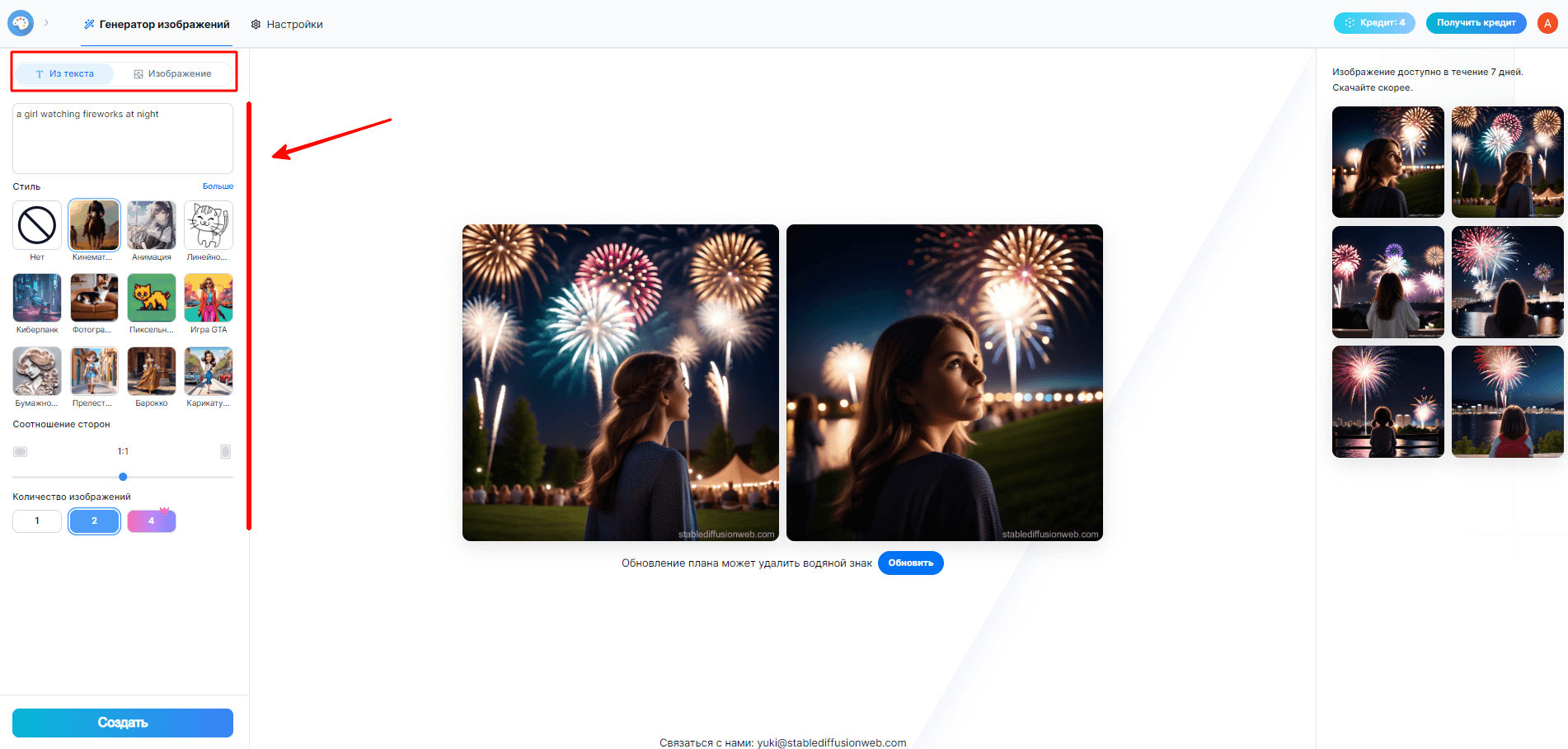

- После этого откроется окно генерации.

Слева вы увидите параметры настройки картинки: стиль, соотношение сторон и количество изображений, которые будут сгенерированы за один раз. Кроме того, сверху есть две вкладки: генерация по тексту и по загруженной картинке. Бесплатно обычно доступны не все варианты настроек, однако, чтобы просто попробовать систему, хватит и имеющихся. Кроме того, количество самих сгенерированных бесплатно изображений может быть ограничено.

- Введите в окно промпта текст, описывающий изображение, которое вы хотите создать.

Он может быть как коротким, так и длинным и подробным. Для примера мы выбрали запрос «девушка смотрит на салют ночью». Укажите стиль и нужное соотношение сторон. Нажмите «Создать» / «Сгенерировать».

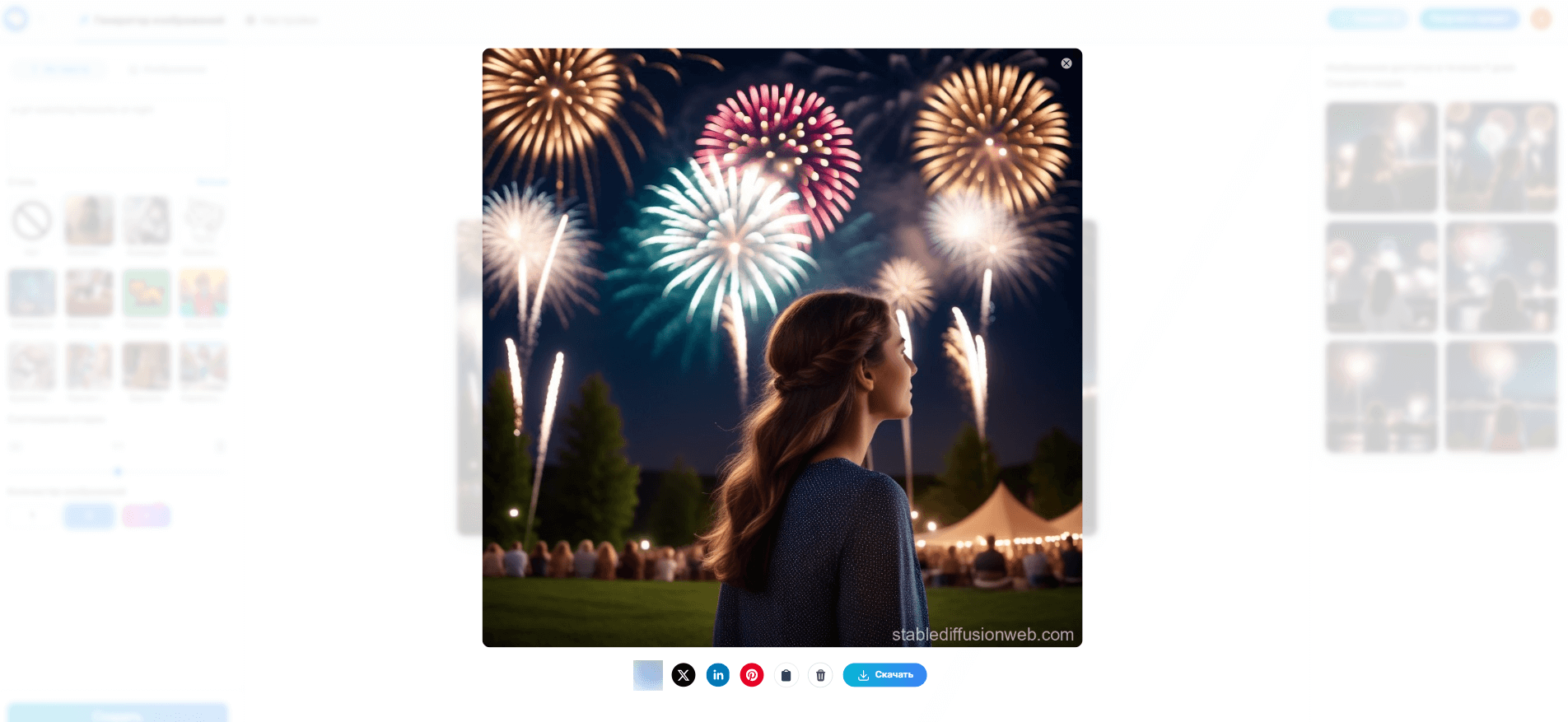

- Любое из созданных изображений можно скачать на компьютер, скопировать в буфер обмена или разместить в соцсетях.

Для этого на картинку нужно нажать: появится интерфейс с возможными действиями. Бесплатно созданные картинки помечаются названием сервиса. Чтобы получать изображения без него, придется заплатить.

Как установить Stable Diffusion на компьютер

Итак, давайте разберем важные моменты этого процесса по порядку. Десктопная версия Stable Diffusion — это программа, которую нужно скачать и установить на компьютер. В ней больше возможностей, чем в онлайн-версии, однако есть и ряд условий для ее использования.

Системные требования

Например, компьютер или ноутбук должен соответствовать определенным системным требованиям:

- операционная система: Windows 10/11, MacOS или Linux;

- оперативная память: не менее 8 Гб;

- видеокарта: NVIDIA с не менее 4 Гб видеопамяти или M1/M2 на Mac;

- свободное место на жестком диске: не менее 10 Гб.

Это минимальные требования для запуска программы Easy Diffusion. Для других они могут немного отличаться: рекомендуем перейти на официальный сайт каждого из описанных ниже сервисов и уточнить данные. Для получения лучших результатов и высокого разрешения изображений, скорее всего, нужно использовать более мощное «железо».

Два способа работы со Stable Diffusion на ПК

Следующее, что важно понимать: установить инструмент на компьютер можно двумя способами — сложным с помощью Git и Python и простым с помощью обычных ПК-программ. Для работы с первым понадобятся аккаунт на GitHub и хотя бы базовые навыки работы с программным кодом. Второй же подойдет обычным юзерам, поэтому далее мы расскажем именно про него.

Программы для работы со Stable Diffusion на ПК

Вот две наиболее популярных программы, которые достаточно просто установить и использовать.

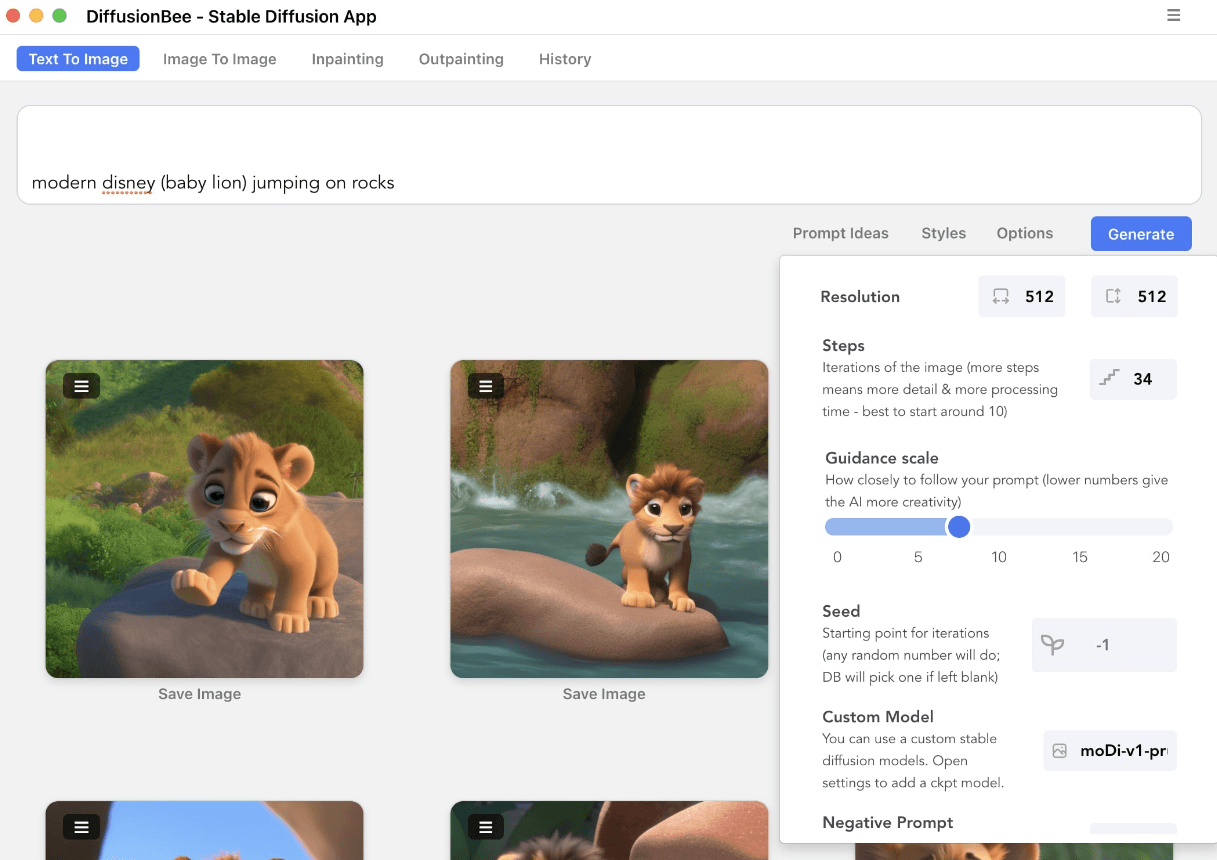

DiffusionBee

Это бесплатное приложение для Mac, которое работает со всеми популярными моделями Stable Diffusion, включая улучшенную модель SDXL для высококачественных генераций по большому числу параметров. Для установки DiffusionBee нужно скачать исполняемый файл с официального сайта, запустить его на компьютере и следовать подсказкам системы. Все необходимые компоненты будут установлены автоматически. Здесь есть интуитивно понятный и визуально приятный интерфейс, а также все необходимые для работы функции и настройки, включая не только генерацию по тексту, но и расширение и дополнение картинок.

Интерфейс DiffusionBee. Источник

Интерфейс DiffusionBee. Источник

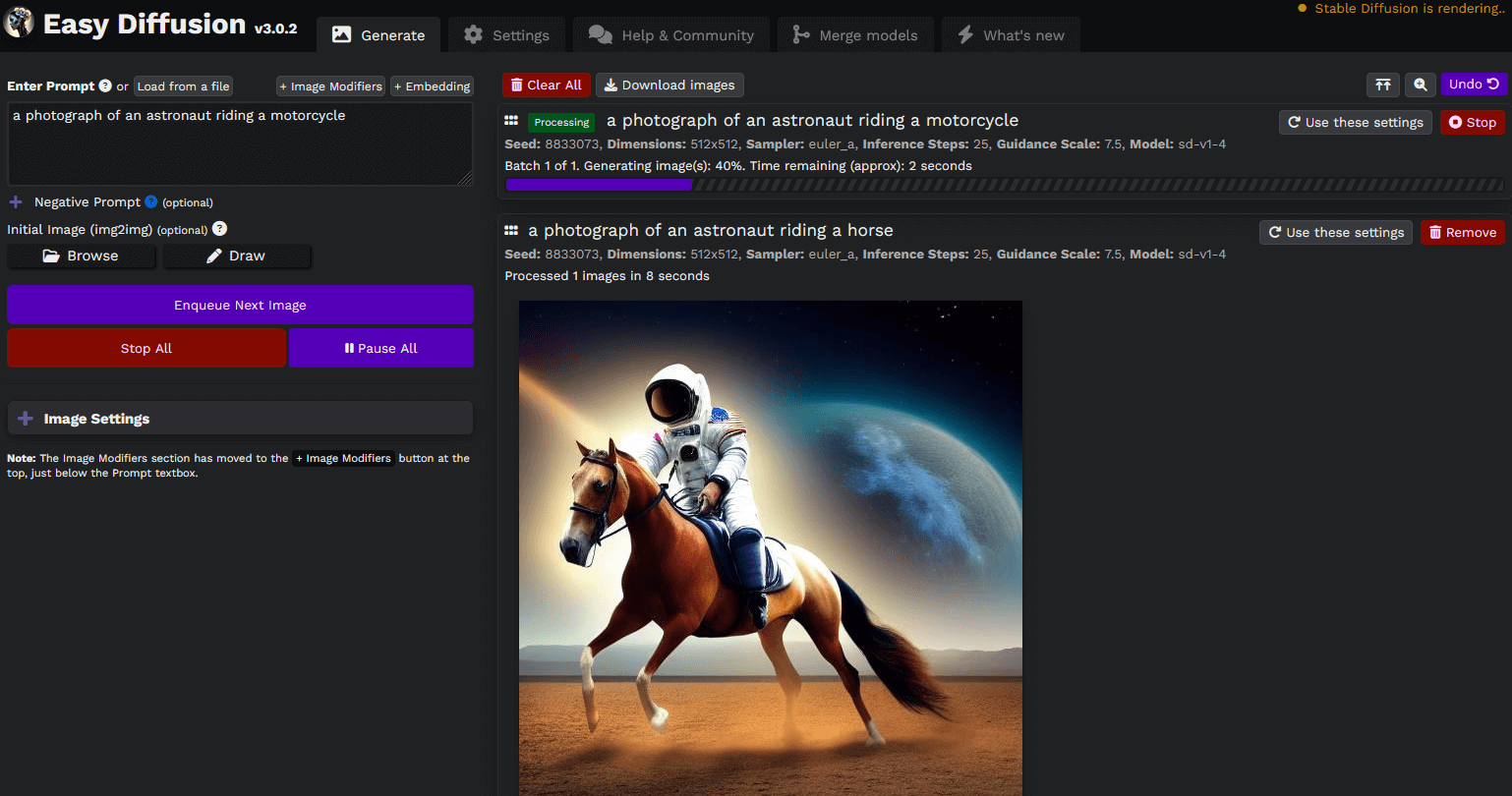

Easy Diffusion

Это очень простое в установке приложение с версиями для Windows, Mac и Linux. Интерфейс тоже содержит все последние модели Stable Diffusion, но дополнительно дает доступ к расширениям, таким как GFPGAN, ESRGAN, SwinIR, LDSR и другим. Каждый из них имеет свою специфику. К примеру, GFPGAN специализируется на работе с лицами людей, а ESRGAN и SwinIR — на увеличении разрешения. Для установки достаточно скачать версию для своей ОС с официальной страницы, открыть exe-файл и далее следовать подсказкам системы.

Интерфейс Easy Diffusion. Источник

Интерфейс Easy Diffusion. Источник

Как работать в Stable Diffusion

Вот несколько важных моментов, которые определяют качество и точность будущих генераций.

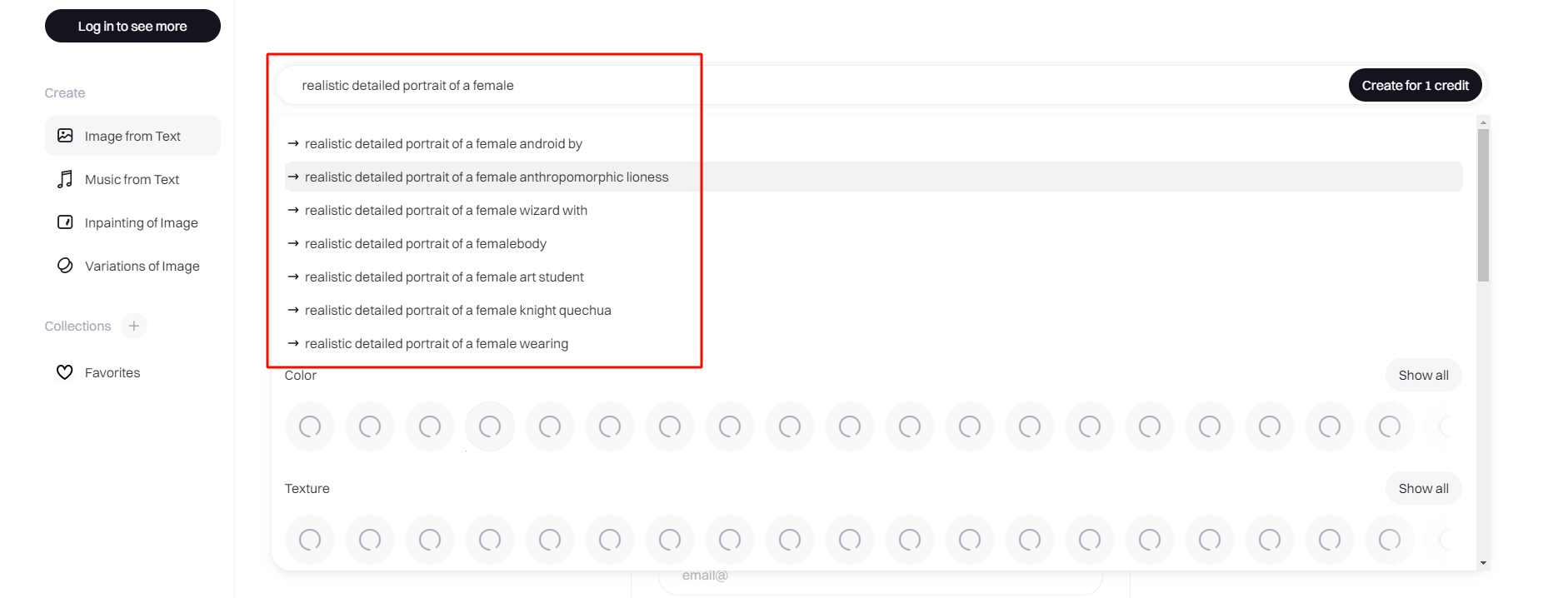

Как составить запрос

Вы можете составить запрос к Stable Diffusion, своими словами описывая изображение. Например, «кот в шляпе и очках, сидящий за столом с книгами и чашкой кофе». В описание можно добавлять дополнительные детали, такие как цвета, формы, позы, эмоции и т.д. Например, «серый кот с зелеными глазами в красной шляпе и синих очках, сидящий за деревянным столом с тремя книгами и белой чашкой кофе, улыбающийся». Если же вы совсем не хотите писать запрос самостоятельно, можно воспользоваться сайтами-генераторами, например Phraser.tech или Promptomania. Они работают так: вы вводите основу вашего запроса, а система с помощью подсказок помогает его дополнить ключевыми словами.

Так формируются подсказки для промпта в Phraser.tech

Так формируются подсказки для промпта в Phraser.tech

Как скорректировать картинку

Если вы недовольны результатом, который получили от Stable Diffusion, вы можете попробовать скорректировать изображение одним из следующих способов:

- Изменить текстовый запрос, добавив или убрав детали, изменяя формулировку или ключевые слова;

- Использовать функцию редактирования изображения (Img2Img), которая доступна и в веб-интерфейсе, и в программах для ПК, работающих на базе Stable Diffusion. Вы можете обрезать, поворачивать, масштабировать, фильтровать или рисовать на уже готовой картинке, делая ее максимально подходящей для своих задач.

- Использовать функцию генерации по референсу, которая позволяет вам загрузить свое изображение или набросок и получить новое изображение, которое будет похоже на него, но с изменениями, которые вы зададите в текстовом запросе. Например, вы можете загрузить фото своего кота и написать «в шляпе и очках», чтобы добавить эти детали на картинку.

Дорисовка архитектурной визуализации с помощью AI от коллектива авторов. Источник

Дорисовка архитектурной визуализации с помощью AI от коллектива авторов. Источник

Юридические и этические вопросы работы Stable Diffusion

Мировое сообщество художников сейчас активно обсуждает вопросы использования генеративных нейросетей для создания искусства и дизайна. Это новая сфера, поэтому многие моменты здесь пока не имеют однозначного толкования.

Один из спорных вопросов заключается в том, кто является владельцем авторских прав на изображения, созданные с помощью Stable Diffusion. Согласно международным конвенциям, авторское право принадлежит человеку, который создал произведение. Однако в случае AI-генерированного искусства не всегда ясно, кто является автором: человек, который предоставил текстовый запрос, человек, который разработал модель, или сама модель. Некоторые юристы утверждают, что AI-генерированные произведения не попадают под понятие авторства, так как они не являются результатом творческого выражения человека. Другие же считают, что AI-генерированные произведения могут быть признаны совместным творчеством человека и машины.

Другой спорный вопрос связан с тем, что Stable Diffusion использует большие объемы данных, взятых из интернета, для обучения своей модели. Это может нарушать авторские права тех художников, чьи работы были использованы в качестве исходных данных, без их согласия или вознаграждения. Кроме того, это может привести к тому, что модель будет копировать стиль других художников, что также может быть воспринято как нарушение авторских прав.

Вот несколько советов, которые помогут использовать генеративные нейросети этично и безопасно с точки зрения закона.

- Стремитесь к оригинальности в своем творчестве. Не используйте Stable Diffusion для простого копирования чужих работ. Применяйте его как инструмент для вдохновения или расширения своих технических возможностей.

- Уважайте права других художников. Если вы используете чужие работы в качестве источника вдохновения или данных для модели, то указывайте их авторство и получайте их разрешение.

- Будьте ответственны за сгенерированные работы. Заявлять исключительные права на AI-картинки и выдавать их за созданные вами вручную сегодня считается дурным тоном. Признавайте свою роль в их создании, но не забывайте про роль модели и ее разработчиков.

- Следите за развитием законодательства в области AI. Оно постоянно меняется и адаптируется к новым реалиям и вызовам. Будьте в курсе последних новостей по этой теме.

Желаем успехов в творчестве!